資訊悅報 Vol.32|REFORM RATE:如何優化多雲成本:5 個降低帳單的最佳實踐

部落格來源網址:How to Optimize Multi-Cloud Cost: 5 Best Practices to Cut Your Bills

如果你正在閱讀這篇文章,

AWS、Azure、GCP、AliCloud,

Gartner 發表的一項研究也印證了這點:由於低效率,雲端支出中最高可能有 70% 會被浪費。

在多年協助客戶優化雲端支出的經驗之後,我們整理出 5 個基本做法,能夠大幅改善你的雲成本。

但是,什麼是雲成本最佳化?

雲成本最佳化不等於單純的「降成本」或「只做監控」。它的核心是

需要提升應用效能嗎?那你就必須把支出對準「正確的執行個體(

以台灣常見情境為例:多雲帳單口徑對不起來時,

你會讓生產設備只用 25% 的產能、卻仍然支付全額嗎?或者你會租下一整層辦公室「

這些正是一些 代價最高昂的雲端成本管理錯誤,可能會傷害你的損益底線。

有效的雲成本最佳化需要:

- 財務營運(FinOps)思維

- 完整可視性

- 主動式管理

- 在浪費發生前就能預防的自動化策略

你的雲成本最佳化目標,最終是要把每一塊錢的投入,

最佳化多雲成本的 5 個最佳實踐

最佳實踐 1:把所有雲成本放在同一個地方監控

可視性碎片化,毫無疑問,是雲支出失控最大的敵人。

圖:AWS、Azure、GCP 與 AliCloud 的碎片化成本管理工具

每個雲服務供應商都提供自己的儀表板、指標與帳務模型。例如,

該怎麼做?

導入一個集中式的多雲管理解決方案,並確保它能提供:

- 在單一儀表板上,對所有雲提供完整可視性

- 追蹤、分析與報告支出趨勢的能力

- 透過地理與網路映射,視覺化跨區域的雲資產,

用於策略規劃與合規需求

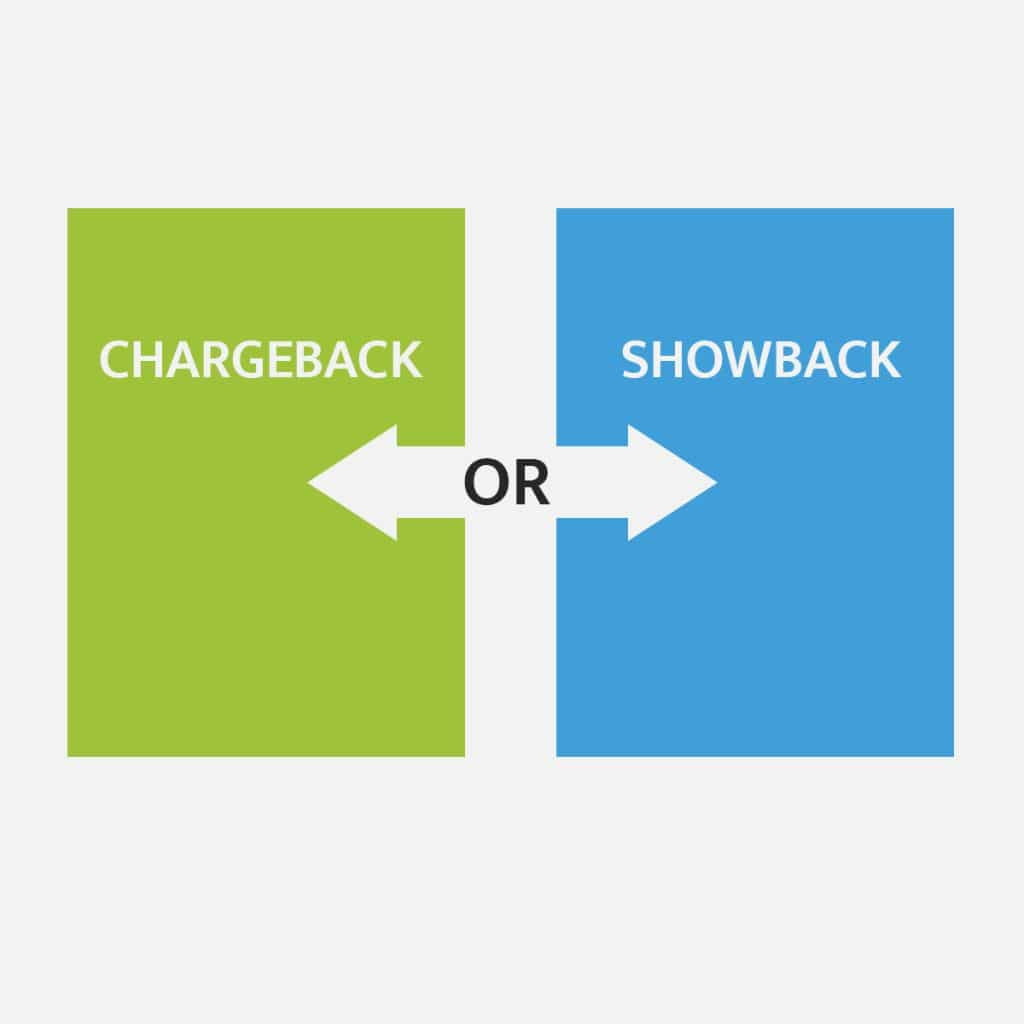

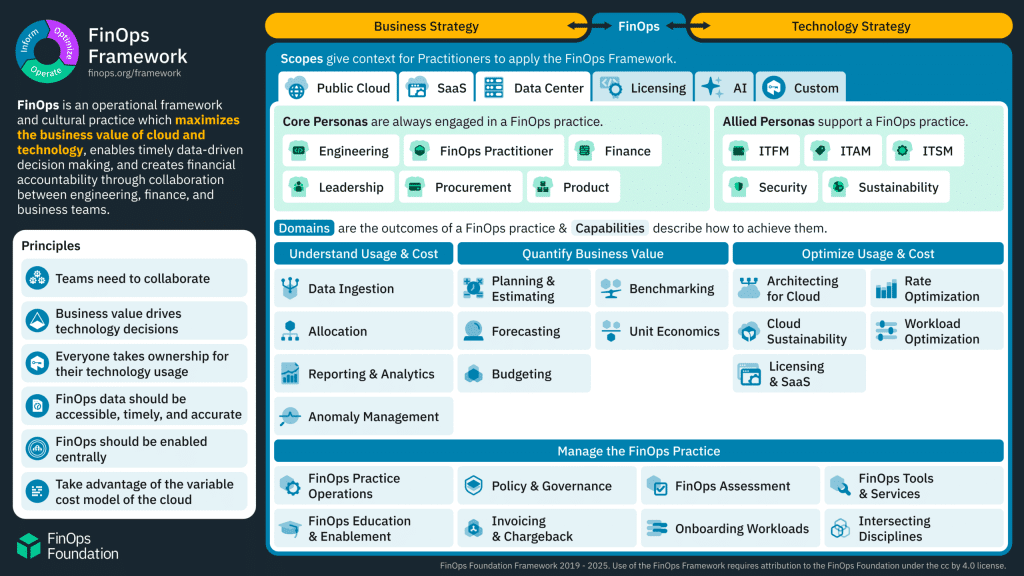

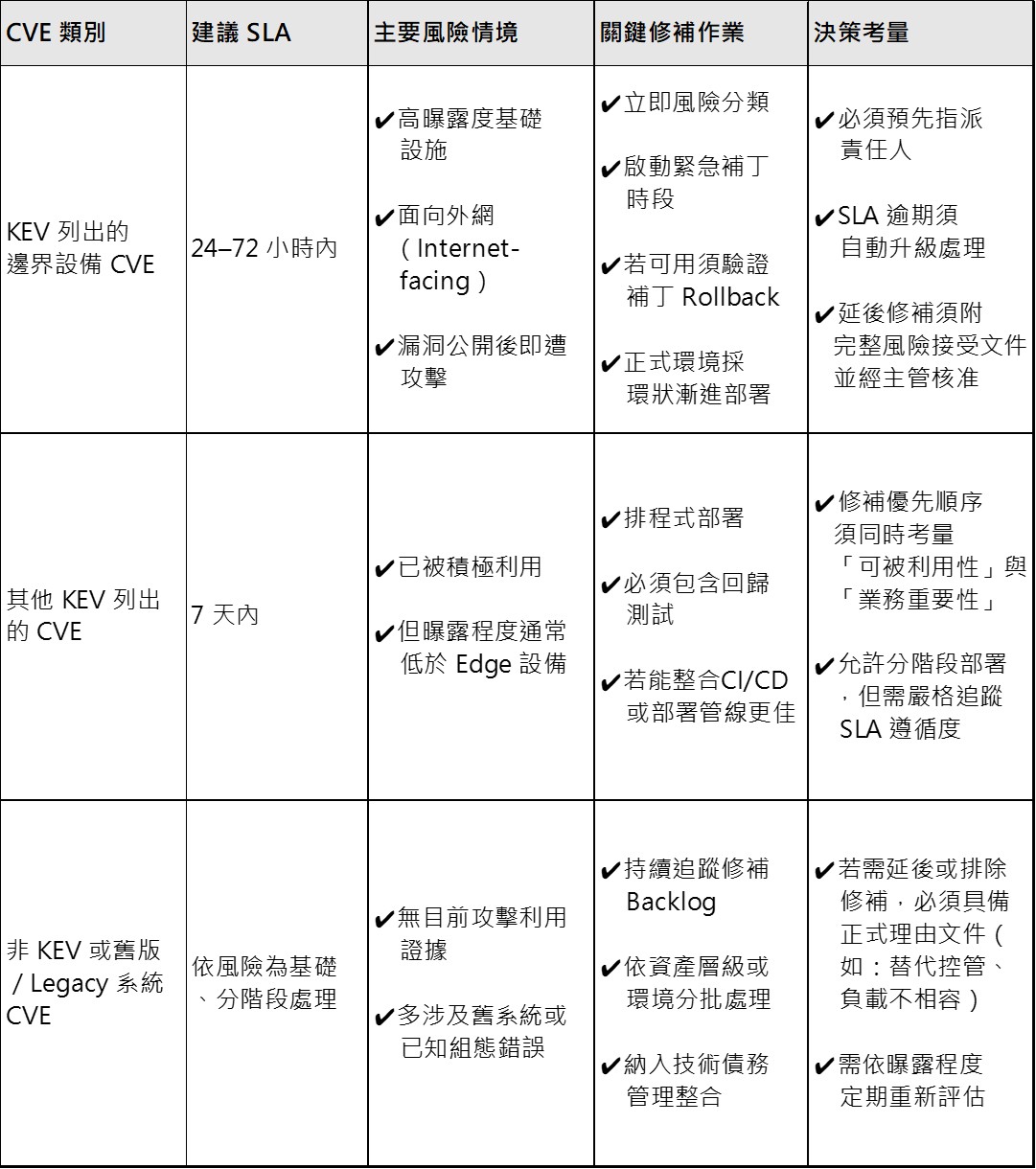

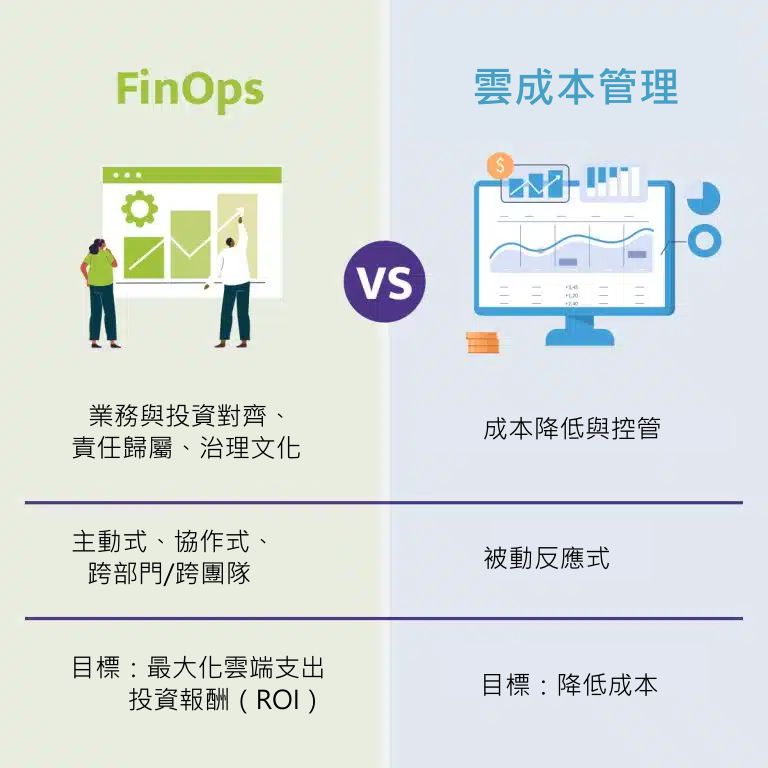

最佳實踐 2:採用 FinOps 思維

當然,追蹤、報告、並最佳化雲支出是好的。

要真正讓企業策略與雲營運成本對齊,採用 FinOps 思維能讓你先行一步。

就像 DevOps 不只是自動化一樣,FinOps 也是一種文化實踐:把工程、財務、產品團隊集合起來,

FinOps 的重點包括:

- 建立跨團隊的用量與成本責任

- 支援即時決策

- 讓雲使用與企業價值對齊

- 做預測、成本分攤、以及「每個功能成本」或「每位客戶成本」

等度量

圖:FinOps vs. 雲成本管理(Cloud Cost Management)

為什麼 FinOps 如此重要?

沒有結構化的 FinOps 實踐時,成本最佳化往往變成零散且被動。

有效的 FinOps 能清楚分配跨團隊與專案的預算,

最佳實踐 3:自動化最佳化與補救

用人工方式管理雲成本,無法規模化。找出低效率只是第一步;

如果你的技術團隊經常被 Excel 分析拖住,還在決定哪些資源該調整大小,

哪些工具能幫上忙?

像 RATE 這樣的進階 FinOps 工具可以優化提供以下功能的能力:

- 進階分析,產生各雲供應商對應的建議,並提供可落地的執行指引

- 自動化補救工作流程,降低落地時間與人為錯誤

- 基於實際使用型態進行資源調整大小,而不是僅憑假設

- 在非活動期間自動關閉閒置資源

最佳實踐 4:最佳化部署

你可能也看過:部署流程會在工作負載進入正式環境之前,

圖:為雲成本最佳化而設計的部署最佳化

這會造成一個根本性的落差:應用如何被部署,與資源如何被消耗,

以 Kubernetes 為例。

透過梳理 Kubernetes 的 FinOps 做法,並處理資源共享、微服務複雜度與動態擴縮,

最佳實踐 5:資源組織與標記

不一致的標記策略影響巨大。我們看過有組織擁有超過 10,000 個資源,標記不一致(甚至缺失),導致無法判斷究竟是哪個團隊、

圖:雲成本最佳化所需的資源組織與標記

你可以怎麼做?

- 把成本分配到各業務單位與應用

- 為每個資源指定清楚的 owner

- 確保跨環境的治理一致性

- 管理臨時資源的生命週期

透過進階 FinOps 工具自動化標記與資源組織,能做到:

- 在所有雲供應商上強制一致的分類法(taxonomy)

- 在資源建立時自動加上標記

- 找出並修正缺失或不一致的標記

- 提供跨環境的標記報告

用 RATE 重新調整並最佳化雲端支出

不要只停留在搜尋折扣方案與省錢技巧;

以上介紹的 5 種做法是您雲端成本優化之旅的簡單起點。

但雲最佳化不是一次性的專案,而是一種持續性的紀律。

你需要一套具成本效益、可靠且全面的 FinOps 解決方案,來承擔這些繁重工作。

RATE 的設計目標,是協助雲支出規模可觀的組織,解決這些特定挑戰:

- 在單一儀表板上,橫跨 AWS、Azure、GCP 與 AliCloud,重新取得完整多雲可視性

- 透過各雲供應商對應建議與自動化執行,最佳化支出

- 在標記混亂與成本突增的「雲端混沌」中,降低焦慮並提升可控性

- 同時支援雲原生資源與 Kubernetes

我們的客戶通常能在 30 天內辨識出約 25% 的「立即可降成本機會」,同時強化治理與責任機制。

準備好讓你的雲端預算與企業願景對齊了嗎?