資訊悅報 Vol.29|CyberArk: 2026年 agentic AI 擴張下的最小權限:從原則到可稽核制度

部落格來源網址:What’s shaping the AI agent security market in 2026|2026年人工智慧代理安全市場的發展趨勢是什麼?

在過去兩年,AI agents 主導了董事會討論、產品藍圖與投資人簡報。

今年,各團隊將努力把願景落地,從展示與試點,

但速度只是方程式的一半。當團隊走出 2025 年的 AI agents 測試期,他們必須重新聚焦於可靠性、可問責制和可控性 。

這就是為什麼 2026 年正在形塑為 AI agent security 市場定型的一年。

AI agents 如何改變企業安全的既有假設

當 AI agents 開始成為應用程式的標配,它們的行為並不像傳統意義上的軟體。

對 CISO 與技術領導者而言,這種更高程度的代理權與自主性,

企業無法在自身或客戶的安全、合規與資料隱私上妥協。同時,

隨著 agentic AI 的採用普及, 安全領導者們正在提出一些非常具體的問題:

- 組織如何發現所有正在運行的 AI agents?

- 每個 agent 的行為,誰是需負責任的人類擁有者?

- AI agents 正在執行哪些動作?是否符合公司的政策?

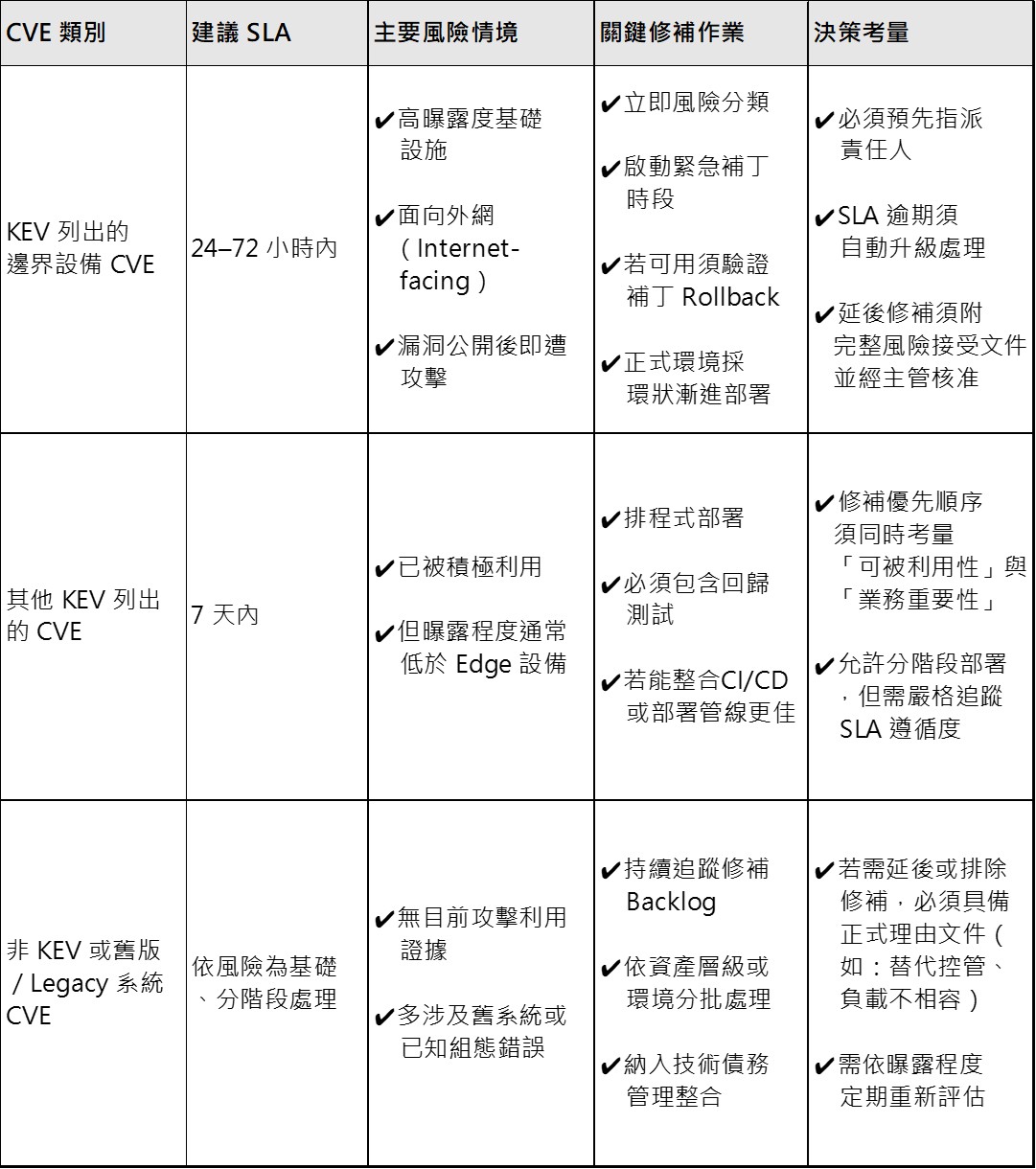

- AI agents 目前擁有哪些權限?這些權限是如何動態演變的 ?

- 當 agents 具備自主性、可擴展且短暫存在時,如何落實最小權限原則 ?

不幸的是,AI agents 無法被整齊地塞進人類或機器既有的安全模型。它們具備超大規模、

把 AI agents 當成服務帳戶、工作負載或應用程式來對待並不足夠。對許多 CISO 而言,agentic AI security 已成為最重大的安全挑戰之一。要在 2026 年克服此挑戰,需要一個可信任的合作夥伴;但對許多人來說,

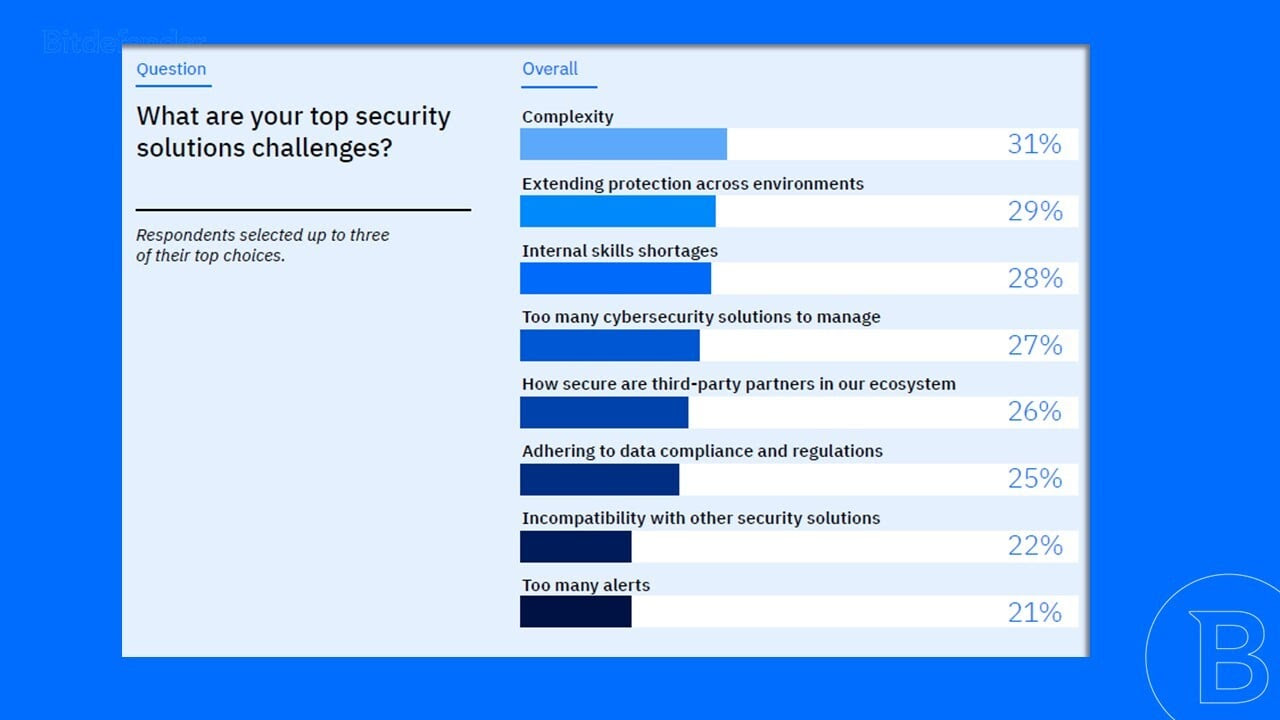

擁擠的市場:為何整併正在發生

想像你就是其中一位 CISO 或技術決策者。你知道 AI 採用是必選題。業務期待它,客戶也在詢問你的產品能力;

你還能向誰求助?

如今幾乎每一家安全供應商都宣稱對 AI agent security 有解方。傳統安全與身分供應商承諾延伸既有產品;

這些活動代表產業確實在加速推進,但同時,整併也在並行發生。

大型供應商正以快速併購來補齊能力,而不是全部自己從零打造。

AI agents 的安全不會獨立存在。它將成為更廣泛安全平台的一部分,而身分、

選擇 AI agent security 合作夥伴的信任挑戰

今年,買方最重要的問題,將從「有沒有這個功能?」或「

從這個起點出發,決策者會要求供應商證明其能否:

- 提供一個整體性解決方案,不只滿足今天,

也能因應技術與安全需求的演進。 - 理解橫跨人類、機器、工作負載與自主 agents 的身分脈絡。

- 在不拖慢創新的前提下落實控管。

- 協助組織從實驗走向安全、可擴展的量產。

當團隊在 2026 年評估 agentic AI security 的合適供應商時,這些問題將成為驅動決策的核心力量。

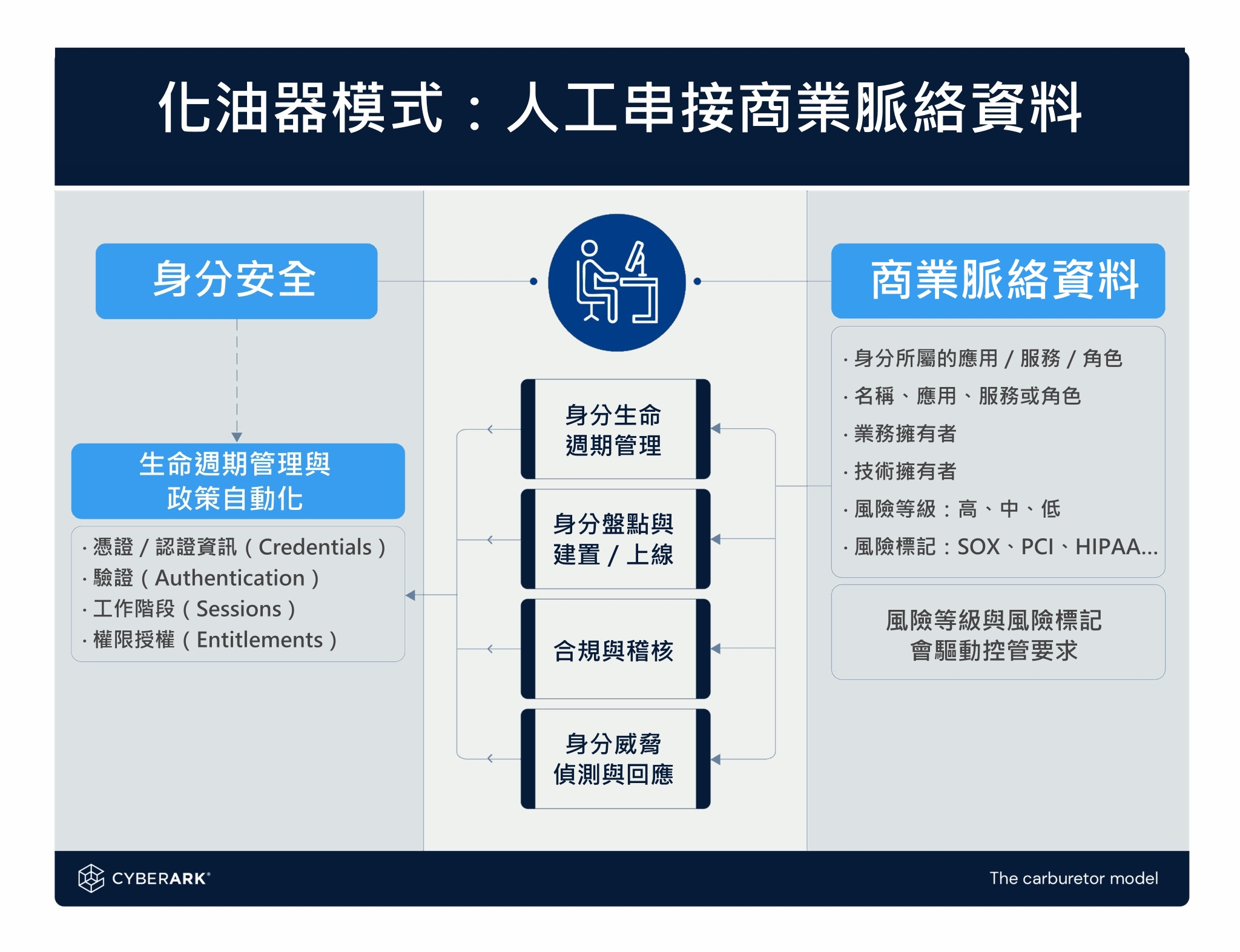

針對不同權限等級的正確解決方案

想在 2026 年把 AI agents 的潛力轉化為效率與成果,團隊無法在安全上鬆懈。這些自主 AI 系統從不休息,卻以機器速度扮演特權使用者的角色。事實上,

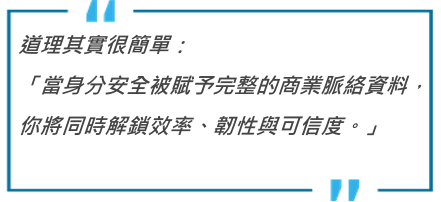

正是在這裡,CyberArk 在市場中的角色變得非常清晰。

超過 25 年來,CyberArk 一直是保護最關鍵身分與特權存取的可信任夥伴。

如今,當 AI agents 進入企業環境,CyberArk 正在延伸既有的身份安全基礎架構,

在一個充滿炒作與承諾、且快速演進的安全市場裡,